☕ # 156 - Tus páginas ya no importan

¡Buenos días!

Comenzamos la mañana del jueves con una selección de las mejores noticias del mundo SEO. Ya somos 5.097 suscritos a #ChuletaSEO, 9 lectores más que hace una semana.

Las últimas semanas han sido especialmente duras en España, con una oleada de incendios que no tiene precedentes. El calor extremo, con temperaturas que han llegado a los 38-40 grados, unido a las rachas de viento y al humo constante, ha hecho imposible ventilar las casas. A todo esto se suma la impotencia de ver cómo, en cuestión de horas, desaparece el trabajo de años: bosques, cultivos y paisajes que forman parte de nuestra vida.

Os dejo una imagen tan impresionante como triste de lo que hemos vivido estos días en el pueblo. La foto está hecha desde España y lo que arde es Portugal. Aunque teníamos también otro fuego detrás que obligó a cortar una de las carreteras durante un par de días.

La próxima semana no habrá newsletter porque estaré de vacaciones, así que volveremos a encontrarnos en septiembre.

NOTICIAS DESTACADAS

📢 Búsqueda agéntica

Análisis del uso de ChatGPT. Metehan Yeşilyurt sigue siendo el SEO del momento. Tras recopilar los 50 factores SEO para posicionar en Perplexity que vimos la semana pasada, se ha currado el análisis de más de 1.800 prompts públicos para entender de qué manera la gente utiliza ChatGPT y cómo podemos beneficiar nuestras estrategias SEO. No es una gran muestra, pero podemos ver algunos aprendizajes interesantes.

La gente no pregunta, ordena: El 75 % de las conversaciones eran órdenes directas, no preguntas. Los usuarios no quieren que les expliquen cómo hacer algo, quieren que la IA lo haga.

Le pedimos que sea alguien: Es muy común que los usuarios pidan a ChatGPT que adopte un rol específico como “Director Creativo”, “Experto Técnico” o “Asesor de Negocios” para obtener respuestas más enfocadas.

Prompts más largos de lo que crees: Olvídate de las búsquedas de dos o tres palabras. La media de un prompt era de 42 palabras. Los usuarios dan mucho contexto para obtener exactamente lo que quieren.

El perfil técnico y comercial domina: Un 40 % de los usos eran de desarrolladores y un 20 % tenían una intención claramente comercial, incluyendo consultas B2B sobre compra de servicios o productos.

Entre el 40-60% de los resultados de búsqueda de IA cambian en solo un mes. Este estudio sobre el 'cambio de citas' muestra lo volátil que es la búsqueda de IA en comparación con la búsqueda tradicional. ¡Y esta volatilidad es aún mayor a largo plazo!

📝 Top Stories

Google lanza la nueva función de Fuentes Preferidas. Ahora los usuarios podemos elegir qué editores aparecen primero en los resultados de búsqueda. Entiendo que estoy ayudará a Google a validar fuentes de calidad. Si tienes un medio digital, no olvides añadir el botón 'Agregar como fuente preferida' para facilitar el trabajo a tus usuarios. De momento sólo está en EE.UU e India, pero irá llegando al resto de mercados; estad preparados.

📲 Tendencias

El cambio en el comportamiento de búsqueda más allá de Google. Un estudio reciente de Cleano revela que el icónico "Just Google it" está perdiendo fuerza. Los usuarios, especialmente la Generación Z, están diversificando sus hábitos de búsqueda, recurriendo a redes sociales y chatbots de IA para encontrar información.

Tendencias clave en el nuevo panorama de búsqueda:

Búsqueda distribuida y estratégica: Mientras Google sigue siendo el preferido para consultas rápidas, los usuarios recurren a plataformas como Reddit, chatbots de IA o buscadores especializados para preguntas más complejas. Esto sugiere que el SEO debe evolucionar para abarcar múltiples canales.

Confianza y claridad: La fiabilidad de los resultados y la claridad del contenido son los factores más valorados por los usuarios. Google, YouTube y Amazon son las plataformas que más confianza generan, mientras que otras como Temu o Shein todavía generan escepticismo.

E-commerce: el precio manda: En la búsqueda de productos, el precio influye directamente en la elección de la plataforma. Sitios como Amazon o eBay son preferidos para artículos caros, mientras que para los más asequibles se opta por plataformas asiáticas.

Esta nueva realidad obliga a los profesionales del SEO a reevaluar su estrategia y a entender dónde busca realmente su audiencia en cada etapa del viaje del cliente, ya que aparecer solo en Google ya no es suficiente.

🛒 Ecommerce

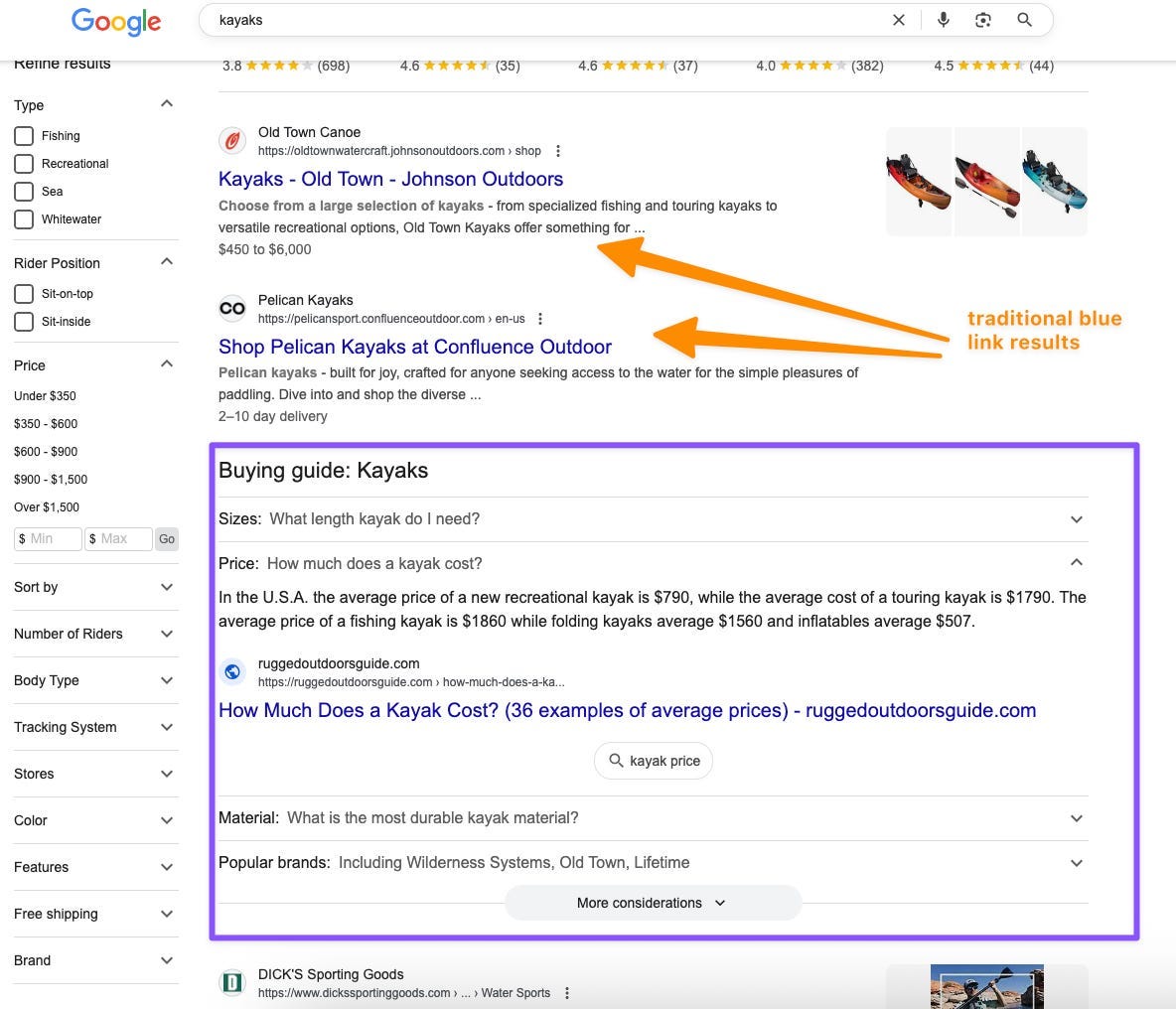

Google está listo para competir con Amazon. El análisis de Kevin Indig muestra cómo los SERPs de compras de Google se han convertido en un mercado completo, con resultados cada vez más visuales y resúmenes de IA que empiezan a reemplazar la presentación de productos tradicional. Esta semana también hemos sabido del lanzamiento de Flight Deals, una nueva función de Google Flights impulsada por IA que te ayuda a ahorrar en tus vuelos y los beneficios de fidelidad en los paneles de conocimiento.

🛠️ Recursos de valor

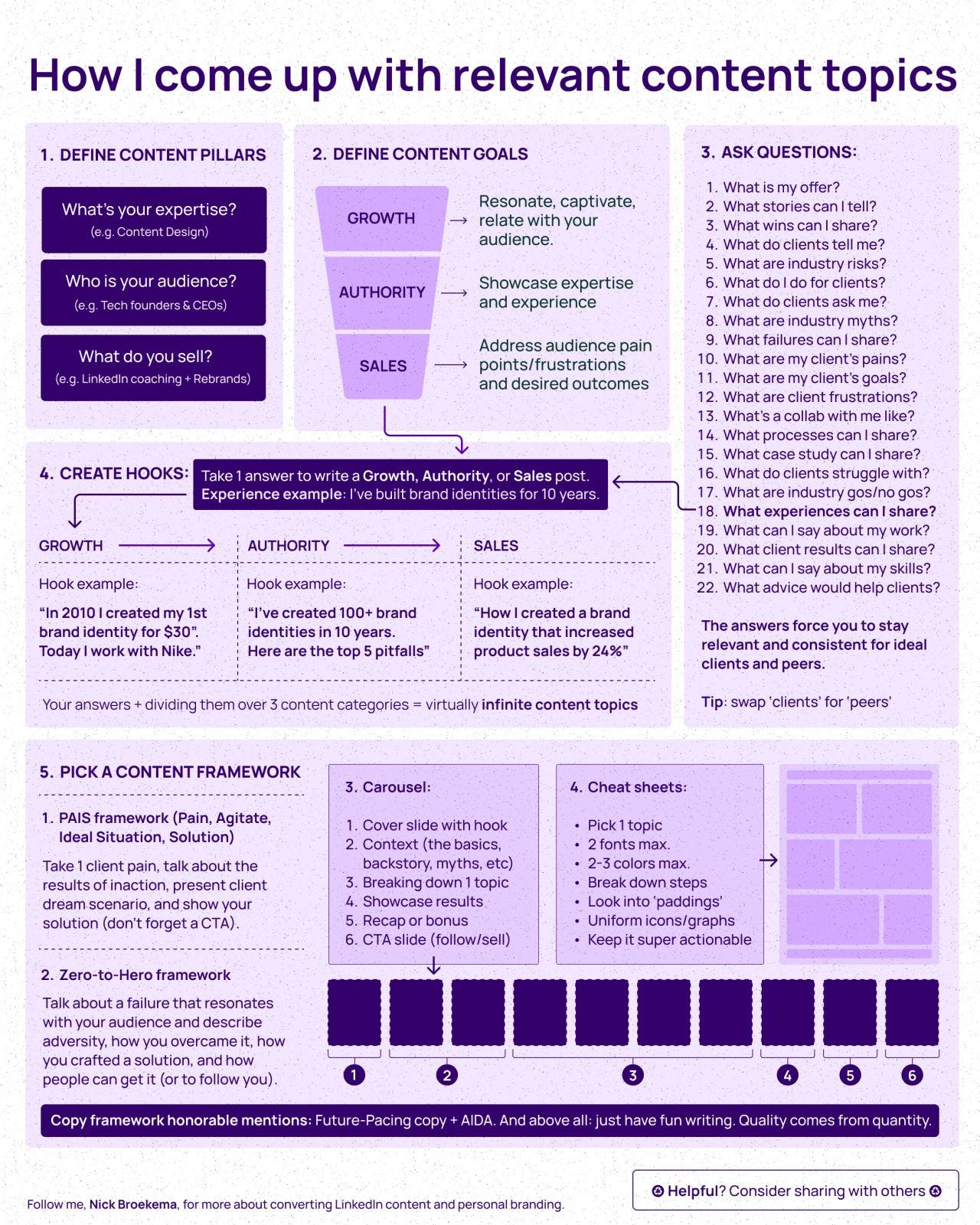

Infografía sobre generación de contenido. A Google no le importa si el contenido es generado por IA. Según Gary Illyes, mientras la "calidad y precisión del contenido" sean altas, el método de creación no importa. Así que aprovecha esta infografía para mejorar y optimizar la calidad de tus contenidos asegurándote de que cumplen con las intenciones de búsqueda de los usuarios.

✨Mejora de procesos

Cómo escribir contenido con IA. Este punto es complementario al anterior. Aquí no hablamos tanto de la calidad del contenido final, sino de la optimización del proceso. En el último episodio de Whiteboard Friday, Andy Chadwick de Moz revela su estrategia de 6 pasos para escribir más rápido y de la manera adecuada, añadiendo tu personalidad y tu voz al usar IA para generar contenido. Si lo vas a hacer con IA, al menos hazlo bien.

📚 UNA REFLEXIÓN / UNA FRASE

Natzir Turrado - “Google ya obtiene el 90% de sus ingresos publicitarios de propiedades propias (Search, YouTube, Gmail, Maps…) y la tendencia no para de crecer. […] las zero-click searches (direct answers, featured snippets, AIO, AI Mode…) no van de mejorar tu experiencia, va de mantenerte el máximo tiempo posible dentro de su jardín vallado.” Quién no lo vea, está demasiado ciego.

🏆 CONSEJO SEO

Usa una página de error 404 sencilla

Gary Illyes ha aclarado en una entrevista con Kenichi Suzuki una duda habitual: ¿las páginas 404 consumen presupuesto de rastreo en Google? La respuesta es sencilla: no lo consumen.

Esto evita que alguien pueda perjudicar a un sitio enlazando masivamente a URLs rotas para forzar a Google a gastar recursos en ellas.

Incluso si un sitio acumula millones de 404, normalmente no supone un problema. Google planifica su rastreo y, cuando detecta que un patrón de URLs siempre devuelve error, reduce de forma automática la frecuencia con la que las revisa.

El verdadero riesgo aparece cuando las páginas de error están mal implementadas. Si el 404 dispara procesos pesados en el servidor, como múltiples consultas SQL, puede afectar al rendimiento del sitio y desperdiciar recursos internos.

Por eso la recomendación de Illyes es clara: usa la página 404 más sencilla posible. En cuanto al presupuesto de rastreo, no hay nada de lo que preocuparse.

🔗 El enlace de la semana

[Aplicación] MCP Search Console: Aprovecho que estamos en agosto -y que hay pocos lectores conectados a Internet- para compartir un proyecto bastante técnico. Si te gusta el tema de la IA y la automatización, explora este MCP para conectar e interactuar con la información de tus perfiles de Google Search Console.

🤖 Inteligencia Artificial y SEO

¿Con qué datos se entrenó ChatGPT?

¿De dónde salieron los datos para entrenar a GPT-4? Llego a esta interesante información a través de Juan González. La periodista Karen Hao lo detalla en su libro Empire of AI, basado en entrevistas con más de 90 empleados de OpenAI.

Todo empezó en 2019 con GPT-2. Su creador, Alec Radford, fue muy selectivo: recopiló solo enlaces de Reddit con al menos 3 votos positivos, creando un dataset de 8 millones de páginas (WebText, 40 GB). El modelo tenía 1.500 millones de parámetros y, aunque pequeño, se entrenó con datos de gran calidad.

Con GPT-3 (2020) la escala cambió: 175.000 millones de parámetros y nuevas fuentes como la Wikipedia en inglés, más enlaces de Reddit, una versión filtrada de Common Crawl y el polémico dataset Books2, que incluía libros pirateados. OpenAI reconoció después este uso y lo eliminó a partir de GPT-3.5.

Para GPT-4 la prioridad fue la cantidad. Se incorporó casi todo Common Crawl sin filtro, una descarga completa de GitHub gracias a Microsoft y datos varios de Twitter, YouTube o Pastebin. En resumen: de la obsesión por la calidad en GPT-2 se pasó al “todo vale” para alimentar el modelo más grande hasta la fecha.