Google Leaks: los secretos del algoritmo de Google al descubierto

Se han filtrado más de 2.500 páginas de documentación interna del equipo de búsqueda de Google asociado a la API del algoritmo

El origen de la filtración

Rand Fishkin, ex SEO y fundador del portal Moz, ha sido el responsable de viralizar la filtración de una serie de documentos presumiblemente de Google en la que, queda patente que muchas de las afirmaciones que hacía el gigante tecnológico en sus redes sociales no eran del todo verdad. Dichos documentos fueron entregados por Erfan Azimi, quién los descubrió en Github, plataforma en la que permanecieron expuestos durante varios días (presumiblemente por error).

Aunque no hay confirmación de que los documentos sean auténticos, algunos ex empleados de Google sí han afirmado que usan el mismo formato y tipología que con los que ellos trabajaban y que, por su estructura e información, dirían que sí son reales.

Actualización: Google se ha pronunciado al respecto y ha confirmado la autenticidad de los documentos. También ha incluido un mensaje de cautela.

Recomendamos tener cuidado con las suposiciones inexactas sobre la Búsqueda basadas en información descontextualizada, desactualizada o incompleta.

Hemos compartido información extensa sobre cómo funciona la Búsqueda y los tipos de factores que nuestros sistemas consideran, al mismo tiempo que trabajamos para proteger la integridad de nuestros resultados contra la manipulación.

¿Qué se ha desvelado?

Partiendo de la base de que creemos que lo que se incluye en estos 2.500 documentos es real, nos enfrentamos a una documentación, medianamente actualizada (hay registros de 2023), de la Search API de Google.

Una API (Interfaz de Programación de Aplicaciones, por sus siglas en inglés) es un conjunto de definiciones y protocolos que permiten que un software se comunique con otro. Las APIs facilitan la interacción entre diferentes sistemas, aplicaciones y servicios, permitiendo el intercambio de datos y la funcionalidad.

Tenemos acceso a cerca de 14,000 atributos (datos) y funciones del algoritmo de Google asociados a esa API. Es decir, información sobre lo que Google utiliza para cualificar y mejorar las búsquedas de su sistema.

Esta filtración no dice qué elementos impactan en el posicionamiento ni qué peso tienen, pero sí nos indica los datos que son registrados por Google y por ende, que pueden tener impacto en el posicionamiento de las búsquedas.

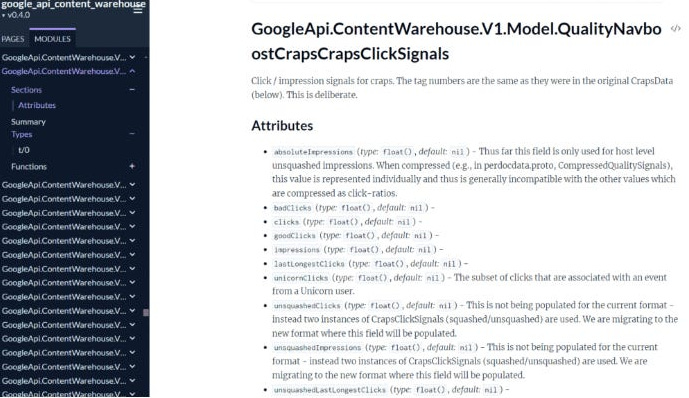

A continuación podemos ver una captura de esta documentación, donde se define una función y los parámetros (valores) que utiliza.

A mí no me ha sorprendido conocer que Google nos miente. Ni es la primera vez ni será la última. A ningún SEO debería haberlo hecho, dado que si te limitas a hacer tu trabajo y analizar lo que funciona y lo que no, eventualmente te darás cuenta de que entra en conflicto con algunas afirmaciones de Google. Y tiene todo el sentido, un buscador no debe (puede) desvelar sus secretos, si no, sólo aquellos que siguen las pautas llegarán arriba, independientemente de la calidad de sus aportes.

Recurro a menudo a la frase de que Google es una empresa, no una ONG y nosotros no somos sus clientes, lo son los usuarios que utilizan su buscador. Nos guste o no, son sus algoritmos y sus normas.

¿Cómo podemos aprovechar esos aprendizajes para potenciar y mejorar nuestras estrategias SEO?

Tras haber analizado los documentos y entendido qué almacena Google sobre las páginas y los usuarios, se han ido asentando algunos conocimientos interesantes.

Principales hallazgos

Importancia de los clics: Los documentos muestran que Google utiliza datos de clics para clasificar sitios web, filtrando clics no deseados y midiendo la duración de los clics (tiempo de permanencia en la página hasta realizar una nueva búsqueda). Utiliza segmentación geográfica y datos de Chrome (navegador) para mejorar la precisión de los resultados. Lo de los clics de usuarios ya lo sabíamos a raíz del juicio antimonopolio, pero estos documentos han ayudado a aclarar mejor de qué manera se almacenan. Por ejemplo, si la sección

chuletaseo.com/emiliono tiene muchos clics, los enlaces de la misma perderán relevancia a ojos de Google. Si por el contrariochuletaseo.com/trucosrecibe clics, sus enlaces transmitirán popularidad.Sistema Navboost: NavBoost (también citado en el juicio) utiliza el número de búsquedas de una palabra clave para identificar las tendencias de búsqueda, el número de clics en un resultado y la relación entre clics largos y clics cortos. También participa en la alineación con la intención de búsqueda, por ejemplo, asociando ciertas búsquedas con una preferencia por imágenes o vídeos. Navboost parece ser usado también a nivel de dominio para evaluar la calidad de los sitios web; los datos y puntuaciones generados por este sistema se integran directamente en los sistemas de búsqueda de Google. Seguramente alineado con el EEAT.

Análisis antes y después de la búsqueda: esto me ha encantado. Google analiza y asocia búsquedas después de haber realizado la principal. Por ejemplo, si busco “Emilio” y luego realizo una segunda búsqueda “Chuleta SEO” y hago clic en

chuletaseo.com, es posible que si se detecta ese patrón, mi página de Chuleta SEO comience a posicionar para la búsqueda de “Emilio”, dado que Navboost entenderá que hay un interés y una asociación.Navegador Chrome: Google utiliza el historial de cookies, los datos de usuarios registrados en Chrome y la detección de patrones (referidos en la filtración como

unsquashed clicksysquashed clicks) como medios para combatir el spam de clics de forma manual o automatizada.Clasificación de enlaces: Google clasifica sus índices de enlaces en tres categorías: baja, media y alta calidad, basándose en datos de clics. Los enlaces de alta calidad pueden transmitir

PageRanky ser filtrados por sistemas de detección de spam. Sí, se hace mención explícita al olvidadoPageRank.Autoridad del sitio: Aunque Google evita el término "autoridad de dominio", sí mide la autoridad de los sitios a través de una métrica llamada "

siteAuthority".Valor de los enlaces: Google estratifica su índice en niveles, donde los enlaces de páginas bien posicionadas o de noticias son más valiosos.

EEAT y contenido: Google almacena información sobre los autores y utiliza un parámetro denominado

OriginalContentScorepara evaluar la originalidad del contenido breve. También utiliza métricas comotitlematchScorepara la relevancia del título. Recuerdo cuando dijeron en X que etiquetar y dar visibilidad a un autor no era un factor prioritario ni decisivo para el EEAT. Menos mal que no les hice caso y aposté por poner el foco a las personas detrás de los contenidos como manera de diferenciar lo humano y profesional, de lo automático y mediocre. Y no me ha ido mal. No hay muchas referencias al concepto EEAT, por lo que podría tratarse más de algo etéreo que en realidad sí es la suma de otros aspectos más terrenales, como core web vitals, autor, acceso responsivo, etc.Enfoque en vídeo: Los sitios con más del 50% de sus páginas con vídeo pueden recibir un tratamiento especial en los algoritmos de Google.

Sitios pequeños: Google tiene una etiqueta para los "pequeños sitios personales", tratándolos de manera diferente en los resultados de búsqueda. Muy posiblemente, para reducir su visibilidad frente a los grandes.

Penalizaciones para los nombres de dominio que coinciden exactamente con consultas de búsqueda de no marca (por ejemplo, mens-luxury-watches.com o milwaukee-homes-for-sale.net).

Whitelists: Durante la pandemia y en momento electorales, Google utilizó un sistema de lista blanca (whitelist) para que aparecieran sitios favorables o que le interesase a Google. También había algo similar para Viajes. Ya sabíamos de antes que Google también maneja blacklists para penalizar sitios que no cumplen con sus prácticas o que les interesa bloquear.

La importancia de la marca. Ya lo comentamos en nuestras predicciones SEO, la marca será muy relevante para el futuro. Ayudará a poner en contexto y valor lo que generamos y representamos. Para pequeñas empresas o páginas de reciente creación, seguramente no se vean grandes resultados hasta que se haya establecido credibilidad, demanda de navegación y una sólida reputación entre una audiencia considerable.

El título sigue siendo un factor relevante para posicionar. Otros factores como los anchor text de los enlaces o la relación de términos de búsqueda con contenidos han ido perdiendo relevancia.

Si tuviera que resumir lo más importante, me quedaría con la generación de demanda de usuarios a nuestros contenidos. Es decir, si puedes generar demanda para tu sitio web entre suficientes usuarios, Google identificará ese patrón y subirás en los rankings sin importar otros factores. Te habrás alineado con Navboost, lo que considero que es el corazón del algoritmo de Google.

Juan Gómez ha realizado una magnífica recopilación de nuevos términos identificados en los documentos, que nos ayudará a poner en contexto parte de la información.

Curiosamente, es algo que llevamos dos años apuntando en varios proyectos y a lo que ya he hecho referencia en alguna de las publicaciones de la newsletter.