Cloudflare y la web invisible para los humanos

La última funcionalidad presentada por Cloudflare -markdown for agents- apuesta por disponer de dos tipologías de página, una para las personas y otra para los rastreadores.

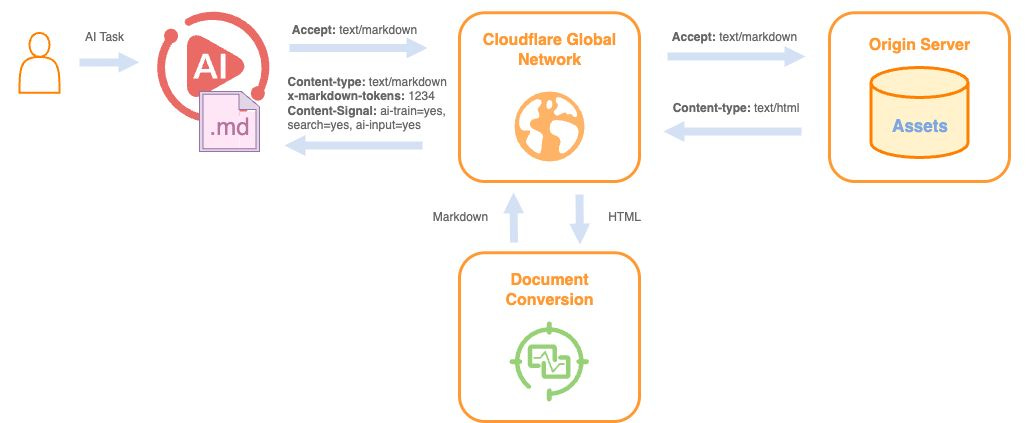

La idea es servir el contenido en formato Markdown a los agentes de IA, mientras los usuarios humanos (nosotros) recibimos la versión tradicional en HTML. Sin alterar la experiencia visual, se crea una capa optimizada para que las máquinas procesen la información de forma más eficiente.

Qué cambia realmente

El elemento más llamativo es la reducción de tokens. Al convertir HTML a Markdown, se puede disminuir hasta un 80% el volumen de información que un modelo necesita procesar. En términos prácticos, eso significa menos coste, más velocidad y menor consumo energético. Eso lo compro pero, ¿se puede garantizar el cambio de HTML a Markdown sin perder contexto? HTML es mucho más que código adicional al contenido, es una experiencia visual que aporta contexto dentro de la página.

El sistema detecta automáticamente si la petición proviene de un humano o de un agente de IA mediante cabeceras de navegación. A partir de ahí, entrega la versión adecuada. Dos experiencias paralelas para dos tipos de lectores distintos.

El contenido, además, se presenta con una estructura más limpia. Sin scripts, sin elementos decorativos, sin capas innecesarias. Solo información organizada.

Más allá del rendimiento

Desde mi punto de vista, este movimiento no es solo técnico. Es estratégico, aunque no tengo del todo claro si será aceptado y les funcionará bien.

Hasta ahora hablábamos de SEO en el contexto de buscadores como Google. Optimizábamos para que un robot entendiera nuestra página y la mostrara a un usuario. Pero los modelos de lenguaje están cambiando esa intermediación. La información ya no siempre se consume desde la página original, sino desde un asistente que la interpreta y la reformula.

Si los agentes de IA se convierten en un canal dominante de acceso a la información (que yo creo que así será), el formato y la estructura dejarán de ser secundarios. La claridad, la jerarquía semántica y la ausencia de ruido serán factores clave. Pero tendremos que ver si esa “teoría” al final es la que vemos.

Podríamos estar ante una evolución natural del SEO hacia algo más amplio: optimización para sistemas de inteligencia artificial.

Una web con doble capa

La idea de una web híbrida me parece interesante, sobre todo si lo hacemos a través de un CDN y nos ahorramos nosotros tener que estar manteniendo cada una de las versiones. Una pensada para humanos. Otra estructural, pensada para máquinas pero que parte de la primera sin que nosotros tengamos que hacer nada.

En el fondo, esta tendencia nos devuelve a lo esencial: el contenido. ¿Os acordáis de la manida frase de que el contenido es el rey? Llegados a este punto, el SEO de contenidos tendría el mayor peso de una estrategia. Se trataría de crear información sólida, estructurada y comprensible más allá del contexto visual.

¿Hay peligros para el SEO?

He estado leyendo sobre algunos posibles fallos que podrían derivar en “cloaking” o falseamiento de los contenidos finales. Al enviar una cabecera específica (Accept: text/markdown) que llega directamente al servidor de origen, se podría identificar si quien visita la web es un humano o un agente de IA y, en consecuencia, mostrarles información totalmente distinta. Recordad que el cloaking es una práctica en contra de las políticas de Google; lo que ve un usuario es lo mismo que tiene que ver su robot.

Tal como se plantea el escenario en Cloudflare, se podrían generar tres potenciales escenarios que perjudicasen al SEO:

Manipulación de datos: Una web maliciosa puede inyectar instrucciones ocultas, publicidad o precios alterados que solo la IA verá, mientras que el usuario humano verá una página normal.

Creación de una “web en la sombra”: Permite generar contenido falso diseñado exclusivamente para engañar a los modelos de lenguaje (LLM), afectando a reseñas, disponibilidad de productos y resultados de búsqueda.

Blanqueo de contenido: Cloudflare convierte fielmente el HTML manipulado a Markdown, dando una apariencia de legitimidad a información que ha sido “envenenada” antes de llegar al bot.

Soy escéptico respecto a cómo será la web del futuro, pero si esta tendencia sigue adelante, quizá no será más vistosa. Pero sí será más legible para quien, cada vez más, la consume en nuestro lugar.