☕ #79 - GEO: El SEO del futuro

¡Buenos días!

Comenzamos la mañana del jueves con una selección de las mejores noticias del mundo SEO. Ya somos 3.761 suscritos a #ChuletaSEO, 35 lectores más que la semana pasada.

Hace unos días recibí una carta. No soy capaz de recordar, entre tanto email y whatsapp, la última vez que alguien se había molestado en escribirme de su puño y letra y pagar para que me llegara. Me hizo mucha ilusión y, además, el sobre era muy original. Lástima que alguien se me adelantó al abrirlo y casi lo rompe del todo.

NOTICIAS DESTACADAS

🌍 GEO: Generative Engine Optimization

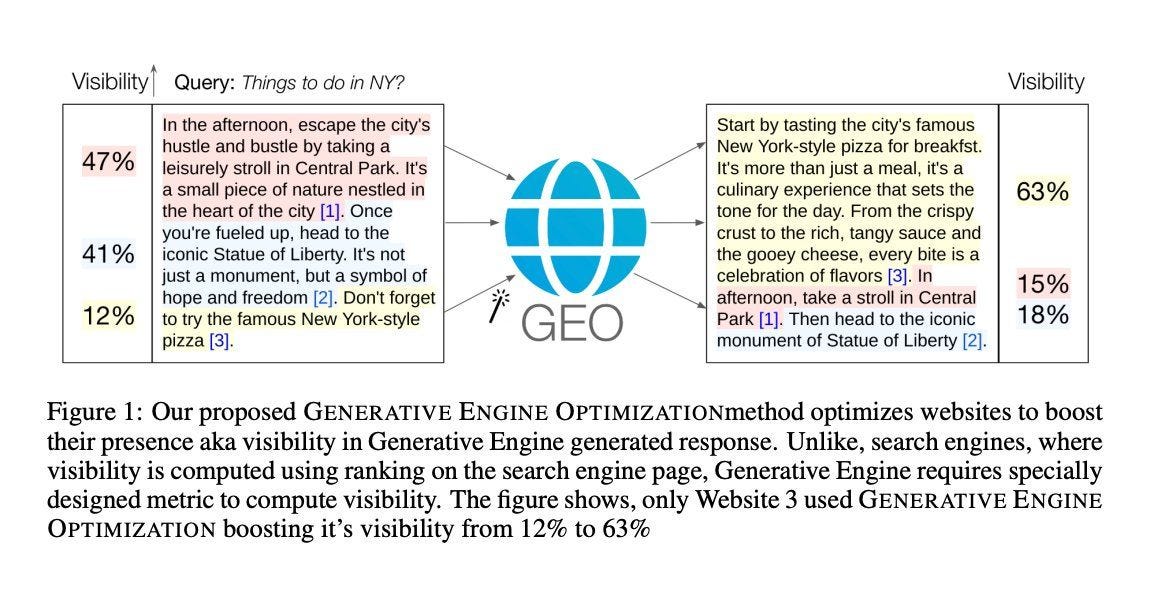

Juan González explica en su publicación de LinkedIn el concepto de Generative Engine Optimization (GEO), que en castellano podríamos traducir como Optimización de Motores Generativos. Se trata de una estrategia diseñada para mejorar la visibilidad de nuestros contenidos en las respuestas de motores de búsqueda generativos.

El enfoque, conocido como GEO, se originó en este paper (versión pdf) donde se examinan hasta nueve estrategias para optimizar la posición de un sitio en sistemas como SGE (Generative Experience de Google), Bing Chat o Perplexity.

Según los autores, esta estrategia ayudó a aumentar la visibilidad en un 40% de las pruebas que realizaron.

Como mencioné en publicaciones anteriores, en la actualidad nos enfrentamos a diversos escenarios, lo que implica la necesidad de desarrollar estrategias SEO específicas para cada uno de ellos. Es importante destacar que lo que puede ser efectivo en un buscador generativo no necesariamente funcionará de la misma manera en el resto.

🌐 Organiza bien la estructura de tu página

Aunque el contenido es el rey, debemos seguir trabajando por optimizar nuestra conversión. Jess nos comparte este template que podemos usar como base para nuestros proyectos.

📝 ¿Tu contenido está optimizado?

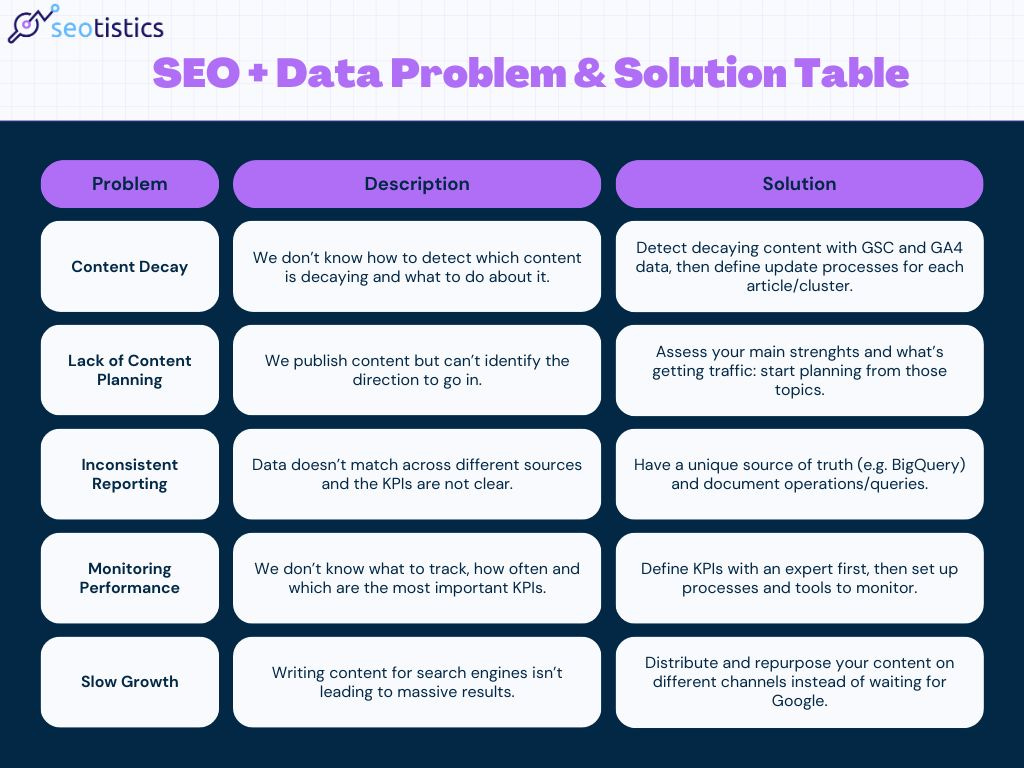

En su análisis, Marco Giordano ofrece un resumen de los problemas más frecuentes que podríamos enfrentar en los contenidos de nuestras páginas web y propone soluciones para optimizarlos, contribuyendo así a una estrategia SEO más efectiva.

Decaimiento del Contenido: Es importante usar datos de GSC y GA4 para identificar qué contenido está perdiendo relevancia.

Falta de Planificación de Contenido: Es crucial comenzar con un plan basado en datos sobre lo que ya está funcionando bien. Mantener un equilibrio entre intuición y datos mejora la calidad del sitio.

Reportes Inconsistentes: Se deben evitar mezclas de fuentes de datos aleatorias y comparar datos de API con los de interfaces de usuario. Es fundamental estandarizar los métodos de reporte.

Monitoreo del Rendimiento: Para sitios grandes, es más importante proteger su participación en las búsquedas que crecer. Utilizar herramientas para rastrear palabras clave y analizar datos es esencial.

Crecimiento Lento: No siempre es malo, pero para muchos sitios, es recomendable usar otros canales para distribuir contenido, en lugar de depender únicamente de motores de búsqueda.

A modo de resumen visual, os dejo la siguiente tabla.

👥 Google, ¿firmamos los contenidos o no?

Ser críticos con la información y hacer vuestras propias pruebas para aprender de la experiencia. En estos últimos años, el magnífico equipo de Google ha compartido tutoriales, consejos e incluso respondido dudas concretas, lo que nos ha ayudado a entender un poquito mejor su ecosistema y cómo alienarnos con él.

Aún así, tened cuidado en cómo interpretáis la información que os dan. No todo es blanco o negro y nuestra experiencia siempre será clave para saber cómo debemos adaptar cada pieza de información oficial que nos llega. Fijaros el interesante debate que hemos generado en Linkedin acerca de si la palabra clave en el dominio ayuda o no al SEO (Google dice que no).

Desde hace tiempo se ha puesto el foco en alinearnos con el concepto de E-E-A-T (Experience, Expertise, Authoritativeness, and Trustworthiness) y una de las prácticas para apoyar la autoridad de un contenido es firmar el mismo con el nombre del autor, su foto y una pequeña descripción.

La semana pasada (en un interesante debate en X) Google informó de que no debemos trabajar la autoría de los contenidos para mejorar el posicionamiento: si queremos incluir información del autor, debemos hacerlo para los usuarios.

Algunos de los puntos más destacados de esa conversación, fueron los siguientes:

“Google no verifica las credenciales [del autor] para propósitos de clasificación”.

“Las firmas de autor no son algo que hagas para Google, y no te ayudan a clasificar mejor”.

“[… las bio de autor] es algo que haces para tus lectores [...] las publicaciones que las utilizan pueden mostrar otras características que nuestros sistemas de clasificación encuentran alineadas con contenido útil.”

Tiene sentido que la bio de autor, por sí misma, no sea un factor para posicionar en el ranking. ¿Qué pasaría si firmamos un contenido malo con un buen autor?, ¿o si inventamos perfiles falsos?. El problema puede ser que la gente entienda que no es necesario y eso sí sería un perjuicio para la estrategia. Que no sea un factor de posicionamiento directo no quiere decir que no sea importante, que lo es.

Google construye modelos para evaluar la calidad de los sitios web, y tener una firma de autor es una parte del patrón para considerar que el sitio web sea bueno o no. No es un factor SEO directo, pero lo puede ser de manera indirecta.

Mi recomendación personal: firmar los contenidos y ofrecer información relevante con el sector. Hacerlo para los usuarios y para los (futuros) sistemas de clasificación de Google.

💻 Cómo bloquear el rastreo de los robots de IA

Con la denuncia de NYT a OpenAI ha proliferado una nueva oleada de bloqueos a los robots de rastreo de inteligencias artificiales.

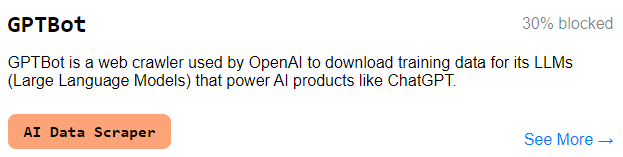

A raíz de ello he descubierto el proyecto Dark Visitors, que recopila todos los user-agents de los sistemas de IA, y además monitoriza el porcentaje de páginas (sólo las top, aunque no indica cuáles monitoriza) que los tienen bloqueados.

El robot más bloqueado es GPTBot (un 30% de las páginas monitorizadas no le permiten el acceso), seguido de Google-Extended (11%) y Anthropic-a (2%).

Bloquear un robot de IA puede que suene contundente, pero en realidad no lo es. Lo único que hacemos es especificar en nuestro fichero robots.txt que no queremos permitirle el acceso y debemos confiar en que sus sistemas lo tengan en cuenta. Si nos ignoran, accederán y extraerán todo nuestro contenido, lo queramos o no.

En este hilo de X nos enseñan a bloquear el acceso a los robots más conocidos. Bastará con usar el siguiente código:

User-agent: CCBotUser-agent: Google-ExtendedUser-agent: GPTBotUser-agent: ChatGPT-UserUser-agent: OmgilibotUser-agent: OmgiliUser-agent: FacebookBotUser-agent: anthropic-aiUser-agent: cohere-aiDisallow: /

TAMBIÉN HA OCURRIDO

📚 Lecturas SEO recomendadas

John Mueller confirma una vez más que utilizar una keyword en nuestro nombre de dominio no nos dará una ventaja en el SEO.

4 formas de potenciar tu análisis de competidores en SERP con aprendizaje automático (machine learning).

John Mueller (Google) reflexiona sobre el impacto de las imágenes generadas por IA vs. las fotos de stock en la experiencia del usuario. Sugiere que las fotos reales son cruciales para productos, mientras que las imágenes de IA o stock son suficientes para mejorar el contenido general

Google cerrará los sitios web creados con Google Business Profile en marzo de 2024 y serán redireccionados al Perfil de Empresa. La redirección funcionará hasta el 10 de junio del 2024.

Posible actualización del algoritmo de Google el 4 de enero que afectaría a búsquedas locales. La herramienta BrightLocal Local RankFlux (SEO local) mostró un aumento significativo en la volatilidad ese día.

Los resultados enriquecidos de Preguntas Frecuentes (FAQ) y Cómo Hacerlo (HowTo) han desaparecido de nuevo, tras lo que parece haber sido una breve prueba de Google.

Vulnerabilidad XSS descubierta en el plugin de Wordpress AMP instalado en más de 100,000 sitios web. Podría permitir a los atacantes inyectar scripts. Se recomienda actualizar al menos a la versión 2.5.1.

Algunos SEOs creen que Google tiene un bug que está haciendo que los sitios web desaparezcan de las SERPs regresando unos días después para y luego desaparecer nuevamente.

La definición de "No indexado" en Google Search Console no significa que "Google no conozca esta página". De hecho, todo lo contrario: una URL "No indexada" en Google Search Console tiene toda clase de información almacenada sobre ella.