☕ #65 - Google te miente

No estás solo, nos miente a todos. Debemos ser críticos con lo que nos dice y confiar siempre en nuestra experiencia.

Buenos días!

Comenzamos la mañana del jueves con una selección de las mejores noticias del mundo SEO. Ya somos 3.386 suscritos a #ChuletaSEO, 47 lectores más que la semana pasada.

Esta semana: Google nos mintió. Los datos de GSC no están mal, son inexactos. Review de Getlinko. Lo que hemos aprendido de la helpful content. Lo más destacado de la entrevista a Gary Illes (analista de Google).

NOTICIAS DESTACADAS

⚠️Google nos mintió: utiliza datos de clics para el posicionamiento de los resultados de búsqueda

Google te miente, pero tranquilo, no estás solo, nos miente a todos. Es una empresa y no una ONG, por eso siempre digo que necesitamos ser críticos con lo que nos dice y fiarnos siempre de nuestra experiencia.

En un testimonio ante un tribunal estadounidense, Eric Lehman, ex empleado de Google durante 17 años, confirmó que el gigante tecnológico utiliza los datos de clics para el posicionamiento de los resultados de búsqueda. Algo que públicamente siempre habían desmentido. Gary Illyes lo confirmó durante el Pubcon Pro de Austin.

Hasta ahora, Google había negado que utilizara datos de clics para el posicionamiento, afirmando que su algoritmo se basaba en una serie de factores de calidad, como la relevancia, la autoridad y la experiencia del usuario.

Sin embargo, el testimonio de Lehman sugiere que Google también tiene en cuenta la cantidad de veces que los usuarios hacen clic en un resultado de búsqueda. Esto significaría que los sitios web que reciben más clics de los usuarios tienen más probabilidades de clasificarse (o mantenerse) en las primeras posiciones de los resultados de búsqueda. Lo que se denomina la ley de los grandes números: lo grande se sigue haciendo grande y lo pequeño, se mantiene pequeño.

Aquí veo dos implicaciones directas

Si te has posicionado por contenidos de valor para tus usuarios, no deberías tener ningún problema y te habrás beneficiado de esto. Al final se trata de un factor más para cualificar una página, aunque por desgracia, favorece a los primeros frente al resto.

Me temo que habrá una proliferación de técnicas para manipular los datos de clics, y esto podría penalizar algunos sitios web. Si veis picos de impresiones pero sin incremento de clics, plantearos si puede deberse a esto (una caída del CTR).

La semana pasada os hablé de la eliminación de los resultados de How To de los resultados de búsqueda. Yo -y otros muchos- habíamos comentado la posibilidad de que estuviera relacionado con la futura búsqueda generativa. Según Gary, trabajador de Google, es debido a que quieren simplificar la página de resultados y para ello eliminan funcionalidades que los usuarios no utilizan.

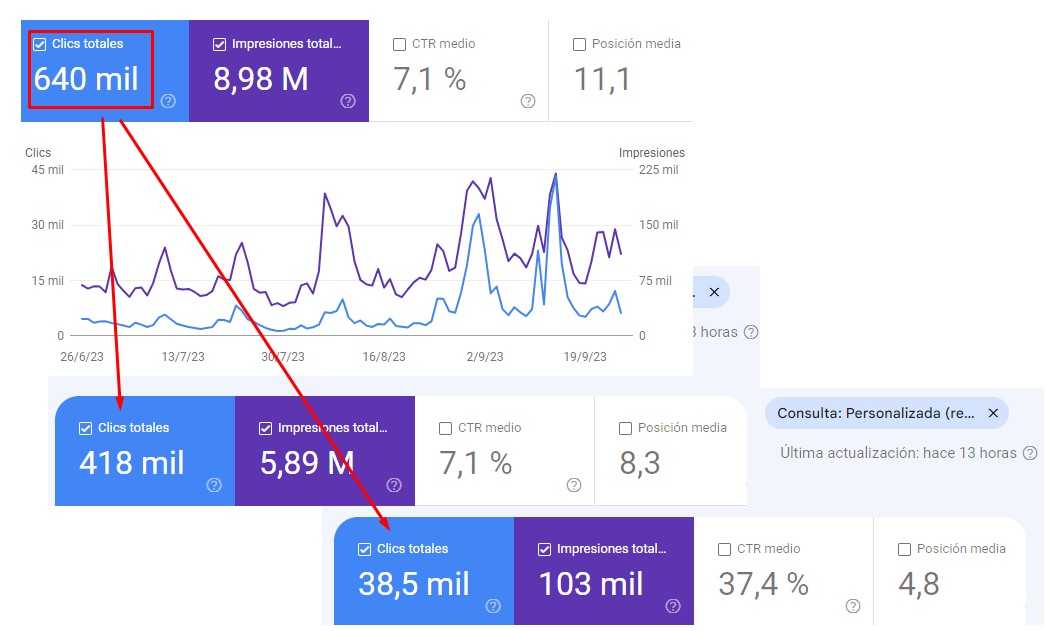

📈 ¿Por qué al filtrar los datos de GSC no son la suma de los totales?

En el informe de resultados de Google Search Console probar a aplicar un filtro para las búsquedas de marca y otro para las de no marca. Si sumáis ambos resultados, veréis que el valor está muy por debajo del total del informe. ¿Está mal?, no, tan sólo es inexacto. Debemos elegir: fiabilidad o rapidez.

Google usa la técnica de filtros de Bloom al manejar una gran cantidad de datos, con el consiguiente ahorro de tiempo y espacio de almacenamiento.

Cuando tienes que trabajar con un gran número de elementos (miles de millones), procesar esa información se vuelve muy difícil. Aquí es donde los filtros de Bloom son útiles. Aceleran las búsquedas prediciendo si algo existe en un conjunto de datos, pero a expensas de la precisión.

Los filtros de Bloom funcionan creando una "huella" de los posibles elementos del conjunto de datos, y luego buscando esa huella en lugar de buscar los elementos reales. Esto puede ser mucho más rápido, pero también puede conducir a falsos positivos, de ahí la inconsistencia en ciertos informes. Cuanto más pequeño es el conjunto de datos que analiza, más precisas son las predicciones.

🚀 Las herramientas no hacen al SEO, pero son sus mejores aliados

En las últimas semanas he hablado de diversas herramientas que podemos utilizar en nuestro día a día para potenciar el SEO de nuestros proyectos y de la importancia de saber discernir funcionalidad (lo aporta la herramienta) de experiencia y criterio (lo aportamos nosotros).

La eterna pregunta de ¿qué aplicaciones son mejores para el SEO? no tiene una respuesta simple, dado que dependerá de cada proyecto y situación. Por ello, en lugar de buscar la herramienta perfecta, creo que es más efectivo si os explico cómo sacar un mejor rendimiento de las que ya conocemos y utilizamos en el día a día.

Por eso me gustaría iniciar un apartado en la newsletter que trate sobre revisiones de herramientas, totalmente subjetivo y destacando lo que para mí son características fundamentales.

He comenzado con Getlinko, una plataforma de link building y branded content, que, bien usada, ahorra mucho tiempo en la búsqueda y gestión de enlaces.

Personalmente, de los tres pilares SEO: indexación, contenido y popularidad, la parte de linking es la que menos me gusta, debido en parte a la gran cantidad de tiempo que hay que invertir si quieres conseguir resultados. Este tipo de soluciones me ha ayudado a agilizar el proceso. Os dejo la reseña completa.

Para futuras semanas me gustaría hablar sobre Google Search Console, Bing Webmasters Tools, ScreamingFrog, Google Lighthouse, Sistrix o ContentKing. Si tenéis alguna en mente sobre la que os interese que profundice, me decís.

💡 ¿Qué páginas han sido afectadas por la última actualización helpful content?

Ya han pasado 14 días desde que la actualización helpful content inició su despliegue (aquí podéis validar si habéis sido impactados).

¿Qué conclusiones ha sacado la comunidad SEO?

El que mucho abarca poco aprieta. Céntrate en (poco) contenido de calidad, en lugar de buscar cantidad. En la era de la IA y donde la marca y autoridad serán relevantes, debemos poner el foco en aquél contenido sobre el que tenemos autoridad.

Las reseñas sobre productos deben ser únicas y originales. Repetir lo mismo que podemos encontrar en otras páginas no nos ayudará a cualificar nuestros contenidos.

Es importante proporcionar evidencia real de que los autores de los contenidos tienen experiencia en los temas sobre los que escriben.

La experiencia de los usuarios en el sitio web sigue siendo un factor clave. No sólo en términos de carga y acceso, sino también de navegabilidad.

La semana pasada hablamos de una táctica para validar y optimizar nuestros contenidos a través de la IA y asegurarnos que están alineados con esta actualización.

🔥 Garry Illes (Google), responde preguntas de los asistentes en la Pubcon de Austin

Os hago un pequeño resumen de las conclusiones más interesantes que ofreció Gary Illes -analista de tendencias para webmasters en Google- en la entrevista de este evento.

¿Por qué Google no indexa todo?. Porque no es eficiente. Es "imposible" acceder a toda la red y procesarla para ofrecer resultados adecuados. No hay recursos y no sería viable, por ello, discernir páginas de calidad cada vez será más relevante.

No es necesario etiquetar el contenido de IA como tal. Si el contenido aporta valor y el usuario aprende de él, será suficiente para Google.

Podemos ver ganancias o pérdidas entre actualizaciones Core. Hasta ahora se creía que sólo había impactos cuando se desplegaban.

Los comentarios pueden ser una manera interesante de mantener una página "activa" a ojos de Google.

Las core web vitals no deberían de ser una prioridad en una estrategia SEO.

Los dominios expirados no traspasarán sus señales a los nuevos desarrollos. Tendrán que empezar desde cero. Aquí tengo mis serias dudas; ellos alegan que tienen acceso al whois del domino y saben cuándo ha cambiado de manos, pero no todo es blanco o negro.

Los enlaces no están dentro del TOP3 de cosas más importantes para Google (si existiera ese TOP3 - palabras textuales-). Se puede posicionar sin ellos.

TAMBIÉN HA OCURRIDO

Lecturas SEO recomendadas

Si le preguntamos a ChatGPT que nos genere un listado de preguntas para hacer a Gary Illes, trabajador de Google, ¿qué creéis que saldría?. Curiosamente, no son preguntas demasiado desastrosas.

Lavado de cara para la plataforma Google Merchant Center. El 23 de octubre se lanzará oficialmente.

Las Core Web Vitals no deberían de ser una prioridad de tu página.

El New York Times genera nuevas bios para sus autores con el objetivo de mejorar su EEAT.

Microsoft lanza nuevas funcionalidades para que dispongamos de mayor control sobre el contenido de nuestras páginas que se usa en BingChat.

El gestor de contenidos Wix habilita IndexNow para todas sus sitios web de pago, lo que facilitará la indexación de las páginas en los buscadores.

Bing retirará la opción de desautorizar enlaces (disavow). Se une así al movimiento de Google que, aunque sigue manteniendo dicha funcionalidad, no recomienda usarla.

Google no recomienda usar los selectores CSS (

beforeoafter) cerca de contenido relevante. Curioso, ¿confundirá a los robots?.Checklist para posicionar páginas de productos.

Muy interesante Emilio. El newsletter qué más me ha gustado hasta ahora tuyo. 🔥🚀