#36 - Panda evolucionó a Coati

Penalización por el mal uso de datos estructurados

No hay que tomarse a la ligera las penalizaciones de Google. Si implementamos datos estructurados con el objetivo de engañar, no sólo nos expondremos a que nos retiren el resultado enriquecido, sino que también nos arriesgamos a una penalización por spam lo que se traduciría en una pérdida de posicionamiento.

Me gusta recomendar esta pequeña guía de Moz de cara a preparar nuestros contenidos para generar resultados enriquecidos. Por cierto, Google recomienda usar punto en lugar de coma, para separar los decimales en las valoraciones numéricas.

Para evitar otro tipo de penalizaciones, cuidado al comprar enlaces y aprende de estos errores en estrategias de linking.

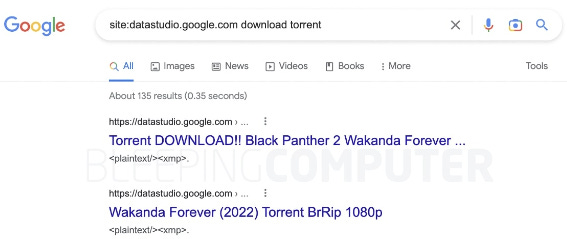

Y hablando de enlaces, fijaros la manera tan curiosa que han encontrado para indexar resultados relacionados con torrents y descargas ilegales: usando paneles de Looker Studio.

Mejorando el proceso de compra

Google ha lanzado la multi búsqueda (Multisearch Near Me) y la realidad aumentada para la compra de zapatos y productos de belleza.

Y para facilitar el seguimiento de los productos que ofrecemos en Google Shopping, dispondremos de un informe dentro de Google Search Console.

Coati, la evolución de Panda

La entrevista de Barry Shwartz con HJ Kim de Google fue increíble. Hemos conocido que el algoritmo de Google, Panda, evolucionó a Coati, y que éste ahora forma parte del algoritmo principal. Con ello, consiguen que cada búsqueda realizada en Google se ve afectada por el E-A-T. Si os interesa el tema, en este artículo Google habla sobre sus sistemas automáticos de clasificación de resultados.

De cara al próximo año, muy interesante conocer la opinión y consejos de grandes expertos SEO recopiladas por Majestic.

Vigila de cerca el robots.txt

Si el fichero existe, devolverá un estado 200 y si no existe, un 404. Antoine comparte en Twitter que en su proyecto, devolvía un error 500, que le informa a Google de un problema en el servidor. Aunque no había problema alguno con el servidor (sólo con el fichero robots.txt), la página terminó desindexada.

Y de paso, os dejo el podcast de Search Off The Record sobre redirecciones así como la actualización en la guía SEO de Google sobre las meta etiquetas a las que ya no darán soporte.

¿Qué herramienta SEO es más fiable?

Difícil pregunta que me llevo haciendo desde que comencé a utilizar SearchMetrics en el 2010. En estos 12 años he pasado prácticamente por todas las del mercado y actualmente, hago uso de Semrush, Ahref, Sistrix, ScreamingFrog y ContentKing. Ese es mi stack SEO de pago.

Gran parte de ellas nos ofrecen una estimación de tráfico orgánico, y es en este punto donde entra el estudio de SparkToro realizado sobre más de 1000 páginas, para dilucidar qué herramienta (Semrush, Ahrefs, Datos o Similarweb) ofrece una realidad cercana a lo que refleja Google Analytics.